在传统互联网时代,数据中心主要用于存储数据和支撑各类业务系统,更接近一座信息仓库。到了 AI 时代,数据中心的角色发生了根本变化:它变成持续产出算力的 AI 工厂。成千上万颗 GPU(如 NVIDIA Blackwell 系列)被高密度部署在同一机房内,需要像一台超级大机器一样协同运行。

算力形态的变化,最直观的结果就是用电需求被大幅拉高。过去的数据中心以通用计算为主,机柜功率通常在5-10 kW;如今面向大模型训练和推理的机柜功率,已经攀升至 120kW、600kW,甚至逼近 1MW 级别。

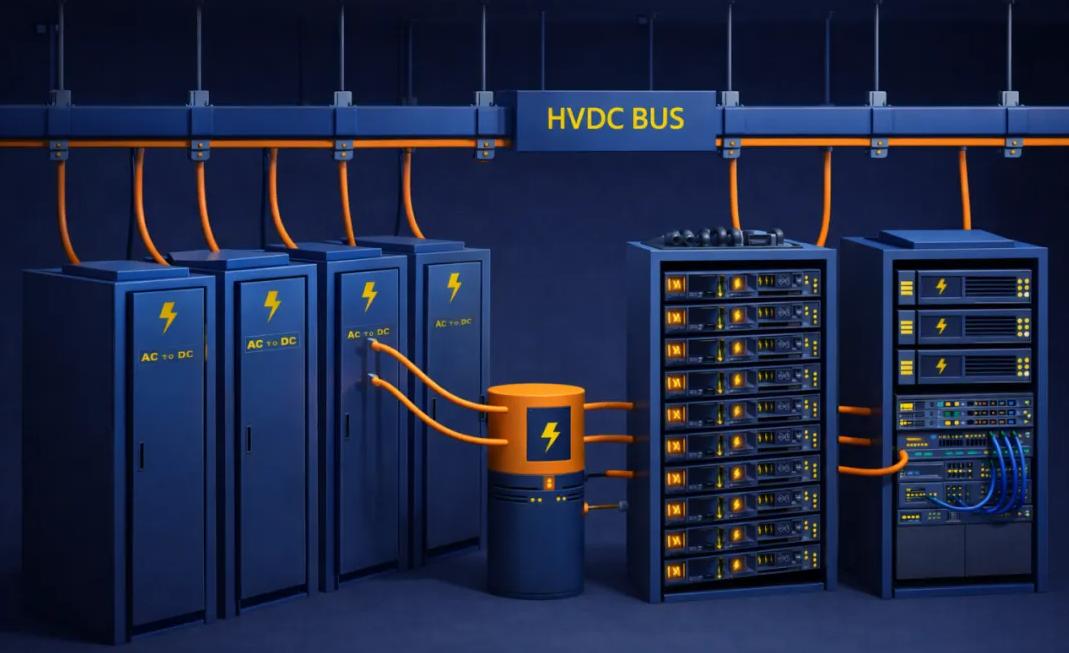

在这样的功率等级下,传统 48V / 54V 直流供电架构的瓶颈开始全面暴露:电流过大、损耗和线缆成本急剧上升,在兆瓦级算力机架场景下已难以持续扩展。为应对这一问题,业界开始转向 800 伏高压直流(800V HVDC)架构,通过提升电压来降低电流,在高功率密度场景下更高效地完成配电。

根据行业预测,到 2030 年,基于 800V HVDC 的配电架构有望覆盖全球约 25% 的新增数据中心容量,逐步成为支撑 AI 算力持续增长的重要基础设施选项之一。

为什么 800V HVDC 才是正解?

要理解为什么要走向 800V HVDC,需要回到两个最基础的物理关系:功率和损耗。

从功率来看:电压不升,电流会失控

已知

功率 = 电压 × 电流

P = V ✖️ I

在这里,P 是机柜需要的总功率,V 是供电电压,I 是通过线缆的电流。可以简单理解为:在同样的功率目标下,电压越高,所需电流越小。

假设一个 AI 机柜的功率 P 已经达到了 1 MW(1,000,000 W):如果沿用传统的 54V 电压,电流 I 将达到惊人的 18,500 安培(A)。18,500 安培电流是什么概念呢?在普通家庭中,一个 1.5 匹的空调运行电流约为 5 安培,电热水器约为 10 至 15 安培。即便是一个设施完备的现代公寓,其入户总空开通常也只在 40 到 63 安培之间。 18,500 安培的电流,意味着在一个仅有冰箱大小的机柜位置上,其流过的电流强度相当于 300 到 450 户家庭在用电高峰期同时开启所有电器的总电流 。

但是如果把电压提高到 800V,电流立刻会降到 1,250 安培。在功率相同的前提下,电流的大幅降低带来连锁优化效应。

从损耗来看:电流一大,问题成倍放大

为什么电流大不好?看第二个公式:

损耗 = 电流² × 电阻

Ploss = I² × R

线路损耗(Ploss)也就是发热,与电流 I 的平方成正比。在大功率场景下,电流压不下来,很多问题接踵而至:

电缆会像网球一样粗

电流的大小直接决定了电线的粗细。根据工程标准,为了安全传输 18,500 安培的电流,铜导线的横截面积需要达到约 4,115 mm² 。 这意味着单根机架电源线的直径将达到约 7.2 厘米,粗细程度与一个标准的网球几乎完全一致 。在实际的数据中心部署中,一个机柜需要多根这样的电缆,这会导致机柜后方根本没有空间容纳服务器,且线缆硬度极大,物理上几乎无法弯曲和施工。

重量级物理负担

传输这种量级的电流需要耗费巨额的铜材。在传统 54V 架构下支撑 1MW 的功率,仅仅一个机柜所需的铜排重量就超过 200 公斤 。 对于一个 1GW(吉瓦)规模的大型 AI 数据中心,如果全部采用传统低压架构,光是机柜内部的铜消耗量就将达到 20 万公斤,这在成本和建筑承重上都是不可持续的 。

恐怖的发热量

已知热损耗与电流的平方成正比。18,500 安培相对于 800V 架构下的 1,250 安培,电流强度提升了约 15 倍,这意味着其产生的发热损耗在理论上会飙升至 200 多倍 。 如果不提升电压,这种电流产生的热量足以在极短时间内熔毁普通连接器,甚至让整个配电系统变成一个巨大的取暖器,导致冷却系统彻底失效 。

机柜空间被电源设备占满

在低压大电流方案下,为了完成必要的功率转换,电源设备(PSU 等)会不断长大:电源相关设备可能占用接近 64U 的空间,而标准机柜通常只有 42–52U,留给服务器和网络设备的空间就非常有限,机柜布局几乎无法落地。

800 V HVDC 可行吗?

800VDC 的走红并不是概念炒作,而是多条产业链叠加的自然结果。

搭上电动车的顺风车

为了实现更高的充电功率、缩短充电时间,保时捷、现代等车企率先在电动汽车平台上大规模采用 800V 高压系统。800V 相关的功率半导体、模块、电缆、连接器、充电设备被迫走向量产化,如今,数据中心转投 800VDC 架构,本质上是顺应产业趋势的借势而为,通过直接复用电动汽车领域已然跑通的高压直流产业链,实现了从技术研发到生态构建的跨行业平替,极大地降低了系统落地的成本。

第三代半导体成熟

800VDC 的真正底气,源于碳化硅(SiC)和氮化镓(GaN)带来的高压微缩化革命。这些第三代半导体器件在大幅提升能效的同时,让复杂的电力转换装置得以实现模块化、标准化量产。业内普遍认为,2025 年前后是这类技术从试点走向规模应用的拐点。

AI 硬件的反向定标

2025 年,NVIDIA 通过官方技术博客正式确立了面向 AI 工厂的 800V HVDC 架构,将其定位于下一代高密度计算的电力基线,并明确了在节能与降低铜耗方面的显著收益。

这种战略构想在产品路线上得到了深度贯彻:NVIDIA 计划将其 MGX 架构演进至全新的 Kyber 机架架构,直接在机架侧采用 800VDC 配电,并配合 2027 年的量产节点实现数据中心级的同步推进。在 GTC 2025 现场,NVIDIA 展示了专为单个 Kyber 机架设计的 800VDC Sidecar 电源单元,旨在驱动承载数百颗 Rubin Ultra GPU、功率逼近 1MW 极限的超级机架。

围绕这一宏伟蓝图,上下游生态已进入对齐时刻:在基础设施端,NVIDIA 联手 ABB、Vertiv、Flex 等巨头,共同研发适配吉瓦级 AI 数据中心的 800VDC 配电、母排及储能方案。而在半导体及电源端,Infineon、Renesas、Navitas、AOS 等厂商纷纷推出基于 SiC/GaN 的高压器件与整流方案,明确锁定从传统 54V 转向 800VDC 架构。

种种迹象表明,800VDC 已不再仅仅是理论上的最优电压档位,它正由头部 GPU 厂商深度背书、并经由全球基础设施体系共同兑现,正式迈向 AI 时代的默认电力配置。

如何演进?800VDC 不是一步到位,而是三种形态

800VDC 转型是一场循序渐进的系统升级:

第一阶段:侧挂式电源柜 (Sidecar)

这是目前的过渡方案。由于计算柜内空间被 GPU 占满,电源模块被移出并放置在独立的侧挂柜中。这一阶段的目标不是最优架构,而是让高功率 AI 机架尽快跑起来。

第二阶段:中心化整流架构 (Centralized)

在房间级进行集中整流,通过直流总线分发。此阶段可消除大量中间转换步骤,端到端效率提升约 5%。

近期报道显示,字节跳动在最新一轮 AIDC 招标中,首次在大规模项目中引入 800V HVDC 方案,计划将高压直流在新建园区中的渗透率提升至约 30%–40%,同步启动楼宇级、数十 MW 规模的 800V 直流配电试点,本质上就是向集中式 800VDC 母线架构过渡。

第三阶段:智能固态变压器 (SST)

终极方案是采用 SiC 芯片实现硅进铜出,将 10kV 电网直接转换为 800VDC。

据行业媒体报道,美团已在张家口产业园启动全球首个面向超大规模数据中心的 SST 智能直流供电系统,项目落地于秦淮数据怀来数据中心园区,由东阳光与台达电子联合提供技术方案,并计划于 2026 年 4 月正式投运。

瑞技数据中心解决方案与服务——从液冷、配电、空间出发,让 800V HVDC 落地更简单

800V HVDC 转型不仅仅是电压数值的更迭,而是一场涉及电力分配、热管理与空间工程的深度系统重构。作为全球 IT 基础设施与 AI 智算中心(AIDC)解决方案供应商,瑞技(ByteBridge)通过遍布全球的交付能力,结合对 AI 工作负载特性的深度理解,提供涵盖架构设计、高密布线、液冷集成、算力集群网络优化在内的端到端解决方案,帮助客户从容应对 AI 基础设施带来的挑战与机遇。

配电(Power):更聪明地供电

800VDC 落地难点不在电压数值,而在保护、隔离及标准化运维体系的重塑。瑞技通过整合全球供应链,提供从变电进线、集中整流、高压直流母线槽到机柜末端的端到端规划方案。我们与行业领先厂商深度合作,将复杂的侧挂柜(Sidecar)或母线链路转化为标准化的交付闭环,并配套严苛的绝缘合规测试与运维 SOP 培训,确保高压资产的安全稳健运行。

液冷(Liquid Cooling):为极致密度而生

800VDC 架构通过精简机柜内冗余的供电组件与风扇,为高密度液冷重构释放了核心物理空间。瑞技液冷解决方案凭借贯穿全生命周期的交付能力,协助客户完成从 CDU 架构选型、管路拓扑设计到二次侧工程实施的深度整合。针对单柜百千瓦级的散热压力,我们提供包括泄漏检测、系统冲洗及水质管理在内的标准化保障,并通过 LCaaS(液冷即服务)模式显著降低企业的前期资金门槛,确保 AI 冷却系统实现从快速上线到长期稳健运行的平滑过渡。

空间(Space):抢回黄金面积

800VDC 架构通过简化电力转换层级,彻底化解了传统低压方案在兆瓦级机架中的物理约束与铜过载风险。瑞技通过全球标准化的交付模板,将电力、冷却与空间布局进行深度协同,不仅实现了单位面积 kW 产出的最大化,更确保了跨区域项目的合规性与快速复制能力,将技术红利真正转化为高密度的算力资产。

2030 行业展望——从技术基准到增长引擎

随着 NVIDIA 等行业巨头确立 800V HVDC 为新一代 AI 工厂的电力基准,基础设施领域正迎来一场深度的架构重构。根据行业深度调研与市场预测,这一转型的实际收益将体现在三个维度:

增量市场的高渗透率

到 2030 年,预计全球约 25% 的新增 IT 容量将原生适配 800VDC/SST 架构 。而在算力密集的 AIDC(智算中心)细分市场,这一渗透率有望超过 60%,成为承载万亿级参数模型训练的基础标配 。

全链路能效的结构性提升

转型 800VDC 可将数据中心端到端的电力转换效率提升约 5% 。对于吉瓦(GW)级规模的 AI 园区,这不仅意味着 PUE 数据的显著优化,更能每年减少千万度级的无效能耗,直接降低碳足迹 。

TCO(总拥有成本)的显著优化

依托于 45% 的铜材用量缩减 、70% 的电源维护量降低 以及约 26% 的机柜有效空间回收 ,数据中心在十年全生命周期内的总拥有成本有望下降 30% 。

800VDC 已超越单一技术指标,成为 AIDC 时代的新算力底座。瑞技也将持续协助全球企业跨越物理瓶颈,构建高效、可持续的算力生态。

如果您正在规划新一代 AI 数据中心,或希望评估现算力基础设施的升级潜力,欢迎联系瑞技,一起为未来打造真正“AI 就绪”的智能基础设施。

请联系我们获取完整数据中心解决方案。