没有人再谈论传统的数据中心了。

AI 的爆发,正在重写一切。

随着大模型、智能体、长上下文训练等新负载的迅猛增长,全球科技巨头不得不重新思考基础设施的底层逻辑:从传统通用型数据中心,迈向真正面向 AI 的原生算力基础设施(AI-Native Infrastructure)。

在这场重塑背后,是新一代人工智能对算力密度、互连效率、热量管理、能源结构和工程标准提出的全新要求。

AI 时代的万亿“新基建”巨头们押注何方?

2025 年 11 月,微软正式启用位于美国佐治亚州亚特兰大的第二座 Fairwater 数据中心,并将其与威斯康星州首座 Fairwater 站点以及 Azure 全球网络深度互联,构建成全球首个 行星级 AI 超级工厂(AI Superfactory)。

这一里程碑式基础设施标志着 AI 计算从单一站点向分布式、弹性、可互操作的“可互换机群(Fungible Fleet)”范式全面转型,能够无缝支撑从万亿参数前沿模型预训练,到微调、强化学习(RL)、合成数据生成、评估管道等全生命周期 AI 工作负载。

Fairwater是对 AI 时代物理极限的系统性重构:每吉瓦电力转化为最大化有效 token 输出。

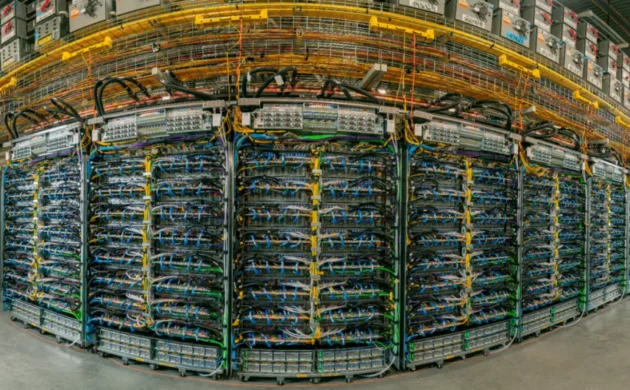

亚马逊超大规模 AI 数据中心——Rainier 项目(图来自《纽约时报》)

2025 年,AWS 将 Project Rainier 全面投入使用,构建起全球最大规模之一的 AI 计算集群,首期部署近 50 万片 Trainium2,并将在年底扩展至超过 100 万片。这一体系已被 Anthropic 用于 Claude 的训练与推理,标志着 AWS 从传统云模式正式迈向“整机级超算”架构。

Rainier 的核心,不是简单扩容,而是通过 Trainium2 + UltraServer + UltraCluster 的全栈自研能力,实现从芯片、互连到数据中心物理结构的系统性重构,使客户能够以云的形式使用一整台 AI 超算,获得可预测、可扩展、可复制的训练性能。

Rainier 同时通过可再生能源、节水冷却和全局效率优化,实现远优于行业的资源利用率,成为 AI 时代云上超算的关键基础设施。

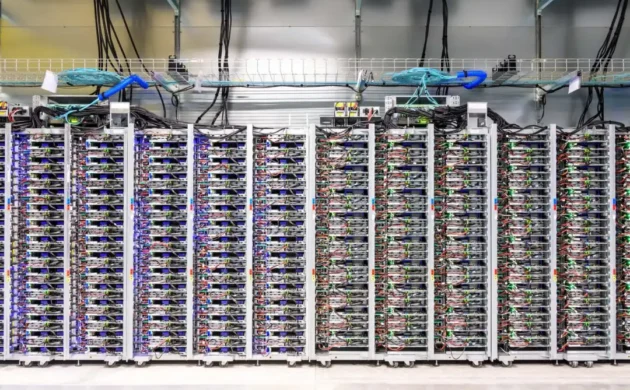

Jupiter 数据中心网络可将多个 Ironwood Superpod 连接成由数十万颗 TPU 组成的超大规模集群(Google)

2025 年,Google 推出第七代自研加速器 Ironwood TPU,并同步扩展基于 Arm 的 Axion 实例,标志其 AI 基础设施从传统 GPU 网络全面迈向 “光互联 × 定制硅” 的新架构。Ironwood 在训练与推理性能上分别较 TPU v5p 和 v6e 提升数倍,已被 Anthropic、Lightricks 等前沿团队用于大规模模型训练与推理。

Google 的创新核心不在于加速卡本身,而在于系统级协同设计:Ironwood 可在一个 Superpod 内连接 9,216 颗 TPU,共享 1.77PB HBM,并通过 9.6Tb/s ICI 构成单一超算域;借助 Jupiter 光网络与 OCS 动态光路,能够实现跨数据中心的行星级算力拼接。

这一路线使 Google 能够构建面向训练与推理全生命周期的高性能集群:以光互联突破传统网络瓶颈、以定制硅提升系统能效、为推理爆发与智能体时代奠定关键基础设施。

比利时 Google Cloud 数据中心内的一排服务器及其网络连接。(图源:Google)

Meta 正在南卡罗来纳州 Aiken 打造全新的 AI 数据中心园区,以支持下一代超大规模算力需求(图源:Meta)

2025 年,Meta 将其基础设施战略推向前所未有的规模,并宣布未来数年将在美国投入至少 6000 亿美元,重点用于生成式 AI、推理服务与下一代超级计算平台的建设。为支撑这一宏大计划,Meta 近期完成多项关键融资与新园区启动:包括与 Blue Owl Capital 达成的 270 亿美元融资,用于打造路易斯安那州迄今最大的数据中心园区;以及在得克萨斯州投资 15 亿美元建设其全球第 29 座数据中心。这些项目的集中上马,意味着 Meta 的年度资本支出将显著上升,并全部围绕 AI 相关基础设施展开。

与其他巨头的“算力极限竞争”不同,Meta 的核心创新并不在单点计算性能,而是在基础设施的全球规模化复制能力。其新一代 AI 数据中心采用统一的高密度模板化体系:从机柜、电力接口、光纤架构到液冷基础设施,全部模块化、标准化,并可直接在全球复制与扩展。通过模板化施工路径、预制化模块单元以及一致性的互连与冷却规范,Meta 将传统数据中心建设周期从数十个月压缩至数月,使 Llama 系列模型能够在全球范围内获得一致、可预测的运行环境。

如今,微软 Fairwater 已正式投产,AWS Rainier 集群进入大规模运行阶段,Google 的 Ironwood TPU 正在全球加速部署,Meta 的新一代 AI 数据中心也将在 2025–2026 年陆续落地。巨头们的路径虽各不相同,但高度一致的方向已经显现:更高的算力密度、更高效的互连体系、更低的 PUE 与更可持续的能源结构。

这一趋势正在重塑全球数据中心工程的方法论,对设计深度、实施质量、多方协同与交付速度提出前所未有的要求。对行业而言,关键不在于概念多先进,而在于是否能够真正把这些新范式转化为稳定可用的算力能力。瑞技的实践表明,拥有成熟交付体系的服务商,正在成为推动 AI 原生基础设施从“纸面蓝图”走向“可复制现实”的关键力量。

当 AI 原生数据中心的建设能力,成为全球科技企业的新门槛。越来越多的技术创新已不再止于概念设计,而需要在真实场景中具备可复制、可运营、可持续的工程落地能力。而要把这些复杂体系真正从蓝图变为可用算力,离不开具备深厚工程实力与跨区域交付经验的专业团队。

在这一行业趋势下,瑞技(ByteBridge)近期在美国圣克拉拉(Santa Clara)为一家全球领先的超大规模云服务商成功交付一座 3MW 高密度 AI 实验室。项目全程仅用 6 个月,在有限的存量空间内构建出面向 AI 负载的高密度算力环境,满足客户快速验证自研 AI 集群性能的核心需求,也再次印证了高水平交付能力在 AI 基础设施建设中的关键作用。

项目概览

客 户:全球领先超大规模云服务商

项目周期:6个月

项目地点:美国 · 圣克拉拉

项目规模: 3MW 高密度 AI 实验室

项目挑战:在“现有机房”里完成一场深度重构

存量空间的改造难度远超新建项目

要在既有结构环境中部署 3MW 算力,需要对承重、通道、散热、电力、布线重新建模。

单柜重量高达 1.8 吨(4000 磅)

这意味着地台、架空系统必须完成“高级别”的抗震与加固。

时间窗口紧张

紧迫的 6 个月交付期限与关键硬件的超长交付周期相互叠加。

多方参与,使协同复杂度倍增

托管服务商、网络团队、硬件供应商……在大量变量中保持进度,是对项目管理的极高考验。

瑞技解决方案

设计与工程优化:重塑 AI 算力底座

- 结构承载与抗震强化:为满足高达 4,000 磅(约 1.8 吨)超重型 AI 机柜的部署需求,瑞技对地台系统进行了结构加固与抗震设计。确保在高密度荷载下,地面具备长期稳定的承载能力与抗震韧性。

- 高密度空间规划:实验室整体布局在有限空间中实现最优算力密度。设计团队通过精准的物理规划,确保空间完全适配和支持高密度 AI 负载对电力、散热和网络互联的严苛需求。

- 架空系统稳固性提升:对头顶线槽、管线系统等架空基础设施实施专业级抗震强化。在承载海量高密度光纤和电力汇流的同时,从根本上保障了高架系统的长期可靠性与卓越安全性,防止因外部震动或重载导致的连锁故障。

基础设施部署:为 AI 高密度集群量身定制

高密度布线与智能配电:针对 AI 算力集群的高功耗与高负载特性,瑞技团队负责部署了高密度结构化布线系统,并集成先进的智能电力分配单元(PDU),确保能源供应稳定、分布灵活,同时为后续扩容提供充足冗余与监控能力。

高效热管理系统:采用热通道封闭(Hot Aisle Containment, HAC)架构,通过隔离热区实现冷却效率最大化,有效应对 AI 集群运行时产生的高热通量,确保关键设备在最佳热环境下稳定运行。

垂直空间效能优化:通过布设头顶线槽与输送系统,将传统地面布线方式“上移”,释放有限的地面空间,提升维护便捷性与空间利用率。不仅有效扩展了可部署机柜数量,也为未来高密度扩容提供结构弹性。

设施与运营提升:打通效率与可持续运维的关键环节

- 空间重构与功能优化:对仓储区、办公区及核心机房区域进行精细化调整,优化人流与物料动线布局,大幅提升空间利用率。同时为未来可能的扩容与运维需求,预留出灵活弹性,打造具备可持续演进能力的场景基础。

- 高效协同与敏捷进度管控:项目执行过程中,瑞技通过每周例行协调会议与动态进度同步机制,主动对接数据中心运营方、供应商与网络团队,保障跨角色协作顺畅,确保各阶段节点在多方参与下依然能够稳步推进、无缝衔接。

- 精密环境保障:设备正式进场前,完成对地板下空腔与表层地砖的深度清洁,并引入颗粒物浓度检测流程,确保室内洁净度达到精密设备运行所需的等级标准,最大程度降低潜在污染带来的系统风险。

端到端交付:让复杂项目高质量落地

全生命周期项目管理:在六个月紧凑工期内,瑞技以高标准推进项目全流程管理:从前期咨询、方案设计,到施工部署、交付验收,均通过专业化团队与标准化流程高效协同,确保每一阶段无缝衔接,按时保质完成交付目标。

多品牌生态系统深度集成:瑞技为客户整合行业一线品牌解决方案,构建高兼容、高性能、高可靠性的系统架构。通过统一规划与严谨选型,实现多供应商方案的深度融合,确保整体系统在高密度 AI 负载下的稳定运行与长期可维护性。

项目成果

项目在既定的六个月周期内如期完成,瑞技成功交付了占地 13,000 平方英尺、可支撑 3MW AI 集群运行的高密度托管实验室。这一项目不仅在存量空间内实现了高能耗、高热密度的工程升级,也为客户构建了可扩展、可持续的 AI 原生算力基础。

在供应链周期紧张、需求多次调整的情况下,瑞技通过单点责任制(Single Point of Contact)将设计、施工、网络、电力、设备等多方资源进行统一协调,在复杂协同环境中保持了稳定推进和高效决策。凭借严谨的工程管理、灵活的排期调整机制及成熟的风险控制流程,整个项目交付过程实现了“无偏差、无延误”。

最终成果获得了数据中心托管服务商与终端超大规模云服务商的高度认可。客户特别肯定了瑞技在工程设计、现场执行、进度管理和多团队协作方面的专业能力。项目交付完成后,客户随即将圣克拉拉地区的后续数据中心扩建与升级任务继续委托瑞技执行,这不仅体现了对瑞技长期能力的信任,也进一步巩固了双方在北美市场的战略合作关系。

打造面向未来的 AI 基础设施

作为 AI 时代数据中心基础设施解决方案供应商,瑞技不仅精通前沿液冷技术,更具备将复杂项目在全球范围内成功落地的能力。

如果您正规划高密度计算的部署、面临跨国数据中心升级,或寻求更高效、可持续的冷却解决方案,瑞技已为您准备好一站式专业服务。

欢迎联系我们,获取完整案例,让瑞技成为您 AI 算力征途上的坚实伙伴,为您的数字化转型保驾护航。